Probabilmente hai già visto i rilevatori di intelligenza artificiale utilizzati da docenti, software antiplagio o piattaforme accademiche. Ma quanto sono davvero accurati? La risposta breve: dipende. Uno studio del 2024 sugli strumenti di rilevamento GenAI ha mostrato che l'accuratezza scende dal 39,5% al 17,4% quando i testi IA vengono leggermente modificati o parafrasati. Un altro report di Appen ha rivelato che nessuno degli strumenti testati raggiungeva il 95% di accuratezza nell'evitare falsi positivi su testi scritti da umani — tutti avevano tassi di falsi positivi superiori al 10%. Per capire come funzionano e quanto ci si possa fidare, vale la pena guardare dietro le quinte.

Cos’è un rilevatore di IA e come funziona?

Un rilevatore di IA analizza un testo per determinare se è stato scritto da una persona o generato da un modello di intelligenza artificiale. Questi strumenti cercano schemi nel lessico, nella sintassi, nella coerenza e nella struttura. Alcuni si basano sul machine learning, altri su regole fisse.

Il loro scopo principale? Individuare testi che "suonano troppo artificiali". Ma le decisioni che prendono non sono sempre affidabili — e l'affidabilità varia enormemente da strumento a strumento.

Questo conta nel mondo reale. In ambito accademico, studenti potrebbero dover dimostrare l'originalità dei loro elaborati. Per i docenti, uno strumento affidabile aiuta a valutare equamente il lavoro degli studenti. Al di fuori dell'università, professionisti e aziende usano questi strumenti per verificare l'autenticità di articoli, report e contenuti web prima della pubblicazione.

Ho testato 5 strumenti: ecco i risultati

Per valutare l'accuratezza in modo pratico, ho testato cinque rilevatori: JustDone Rilevatore IA, GPTZero, Turnitin, Copyleaks e Originality.ai.

Ho utilizzato 100 campioni: 50 scritti da studenti universitari italiani, 50 generati da ChatGPT in italiano. Ogni testo è stato analizzato da tutti e cinque i rilevatori per tracciare i falsi positivi (testi umani segnalati come IA) e i falsi negativi (testi IA segnalati come umani).

Risultati principali:

| Strumento | Falsi Positivi (Umano segnalato come IA) | Falsi Negativi (IA segnalata come Umano) | Accuratezza Complessiva |

|---|---|---|---|

| JustDone AI Detector | 8% | 12% | 90% |

| GPTZero | 20% | 10% | 85% |

| Turnitin AI Detection | 28% | 8% | 82% |

| Copyleaks | 18% | 15% | 83% |

| Originality.ai | 25% | 10% | 82.5% |

* Una nota sulla trasparenza: questo test è stato condotto internamente dal team JustDone. Abbiamo cercato di essere obiettivi, ma è giusto che tu sappia chi ha eseguito l'analisi. I risultati riflettono le nostre osservazioni — ti incoraggiamo a fare i tuoi test per verificare.

Cosa significano questi numeri? L'accuratezza complessiva considera quanto spesso lo strumento identifica correttamente sia i testi umani che quelli IA. I falsi positivi sono particolarmente problematici: uno studente che scrive un testo autentico potrebbe essere ingiustamente accusato. I falsi negativi, invece, riducono l'utilità dello strumento per i docenti.

Nessuno strumento è perfetto. Anche JustDone, che nel nostro test ha mostrato i risultati migliori, ha comunque un tasso di errore del 10%. Questo significa che su 100 testi, circa 10 verranno classificati in modo errato.

Esempi concreti: dove i rilevatori sbagliano

Vediamo alcuni casi reali per capire meglio dove questi strumenti falliscono.

Esempio 1: Testo umano segnalato come IA

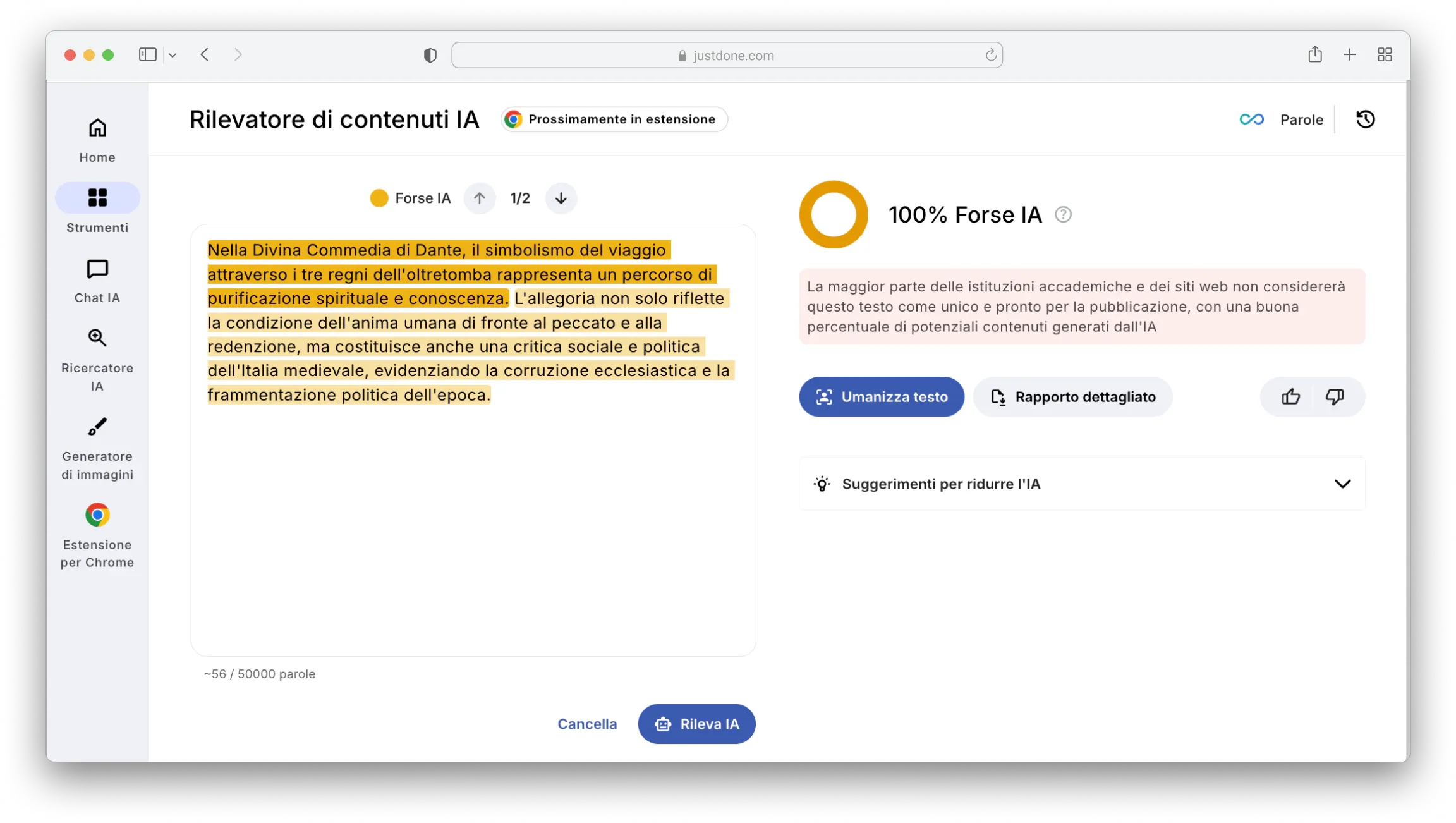

Nella Divina Commedia di Dante, il simbolismo del viaggio attraverso i tre regni dell'oltretomba rappresenta un percorso di purificazione spirituale e conoscenza. L'allegoria non solo riflette la condizione dell'anima umana di fronte al peccato e alla redenzione, ma costituisce anche una critica sociale e politica dell'Italia medievale, evidenziando la corruzione ecclesiastica e la frammentazione politica dell'epoca.

Turnitin e GPTZero hanno segnalato questo paragrafo autentico scritto da uno studente come generato dall'IA. Rilevatore IA di JustDone lo ha riconosciuto come autentico, ma questo non significa che funzionerà sempre così — la scrittura accademica formale rimane una zona grigia per tutti i rilevatori.

Esempio 2: Testo IA passato come umano

Il cambiamento climatico rappresenta una sfida globale complessa che minaccia la biodiversità, disturba gli ecosistemi e impatta sulla salute umana. I suoi effetti includono l'innalzamento del livello del mare, l'aumento della frequenza di eventi meteorologici estremi e cambiamenti nella produttività agricola. Sforzi internazionali coordinati focalizzati sulla riduzione delle emissioni di carbonio e sull'adozione di pratiche sostenibili sono cruciali per mitigare questi impatti e proteggere il pianeta.

Questo brano generato dall'IA è stato leggermente rifinito ed è riuscito a passare inosservato attraverso Copyleaks e Originality.ai. JustDone lo ha segnalato correttamente, ma anche qui: testi IA ben editati rappresentano una sfida per tutti gli strumenti sul mercato.

Il problema dei falsi positivi

Immagina di scrivere un saggio completamente da solo, consegnarlo, e scoprire che il tuo professore lo ha fatto passare attraverso un rilevatore che lo ha segnalato come IA. Questo si chiama falso positivo, ed è frustrante quanto ingiusto. Molti strumenti sono eccessivamente sensibili. Vedono una scrittura strutturata o formale e presumono che sia generata da una macchina. È un problema serio soprattutto per chi scrive bene o in modo accademico.

Esempio 3: Scrittura complessa interpretata male

Il romanzo 'Se questo è un uomo' di Primo Levi esplora la condizione umana attraverso la testimonianza diretta dell'esperienza concentrazionaria. L'autore utilizza un linguaggio preciso e controllato per descrivere l'indicibile, trasformando il trauma personale in una riflessione universale sulla dignità umana. La sua prosa scientifica, influenzata dalla formazione chimica, diventa strumento di resistenza contro l'oblio e la negazione storica.

Tre rilevatori hanno segnalato questo testo autentico come generato dall'IA. Questo dimostra perché un alto tasso di accuratezza non significa automaticamente che uno strumento sia affidabile per gli studenti.

Il problema dei falsi negativi

Al contrario, i falsi negativi accadono quando un testo scritto dall'IA viene scambiato per umano. Per lo studente potrebbe sembrare meno grave, ma per i docenti che si affidano esclusivamente a questi strumenti è un problema serio.

Esempio 4: IA modificata che sfugge al controllo

La tecnologia dell'intelligenza artificiale promette maggiore efficienza e innovazione in molti settori, ma solleva anche importanti preoccupazioni etiche. Questioni come l'invasione della privacy, la sorveglianza e la perdita dell'autonomia umana richiedono un'attenta considerazione. Sviluppare sistemi di IA trasparenti con meccanismi di responsabilità integrati è vitale per bilanciare il progresso tecnologico con il rispetto per i diritti umani e i principi etici.

Questo testo generato dall'IA e leggermente modificato è sfuggito a Turnitin e Originality.ai. Il contenuto IA editato rimane il punto debole di quasi tutti i rilevatori attualmente disponibili.

Cosa ci insegnano i test reali

Nel nostro studio, abbiamo utilizzato 100 campioni di scrittura: 50 scritti da studenti italiani e 50 generati da ChatGPT. Abbiamo poi inserito quei testi in cinque rilevatori, incluso il nostro. Ecco alcuni punti chiave:

- GPTZero era discreto nell'individuare l'IA ma spesso etichettava erroneamente la scrittura umana formale.

- Turnitin era eccessivamente rigido, segnalando troppi saggi scritti da umani.

- Copyleaks e Originality.ai hanno avuto più difficoltà con il contenuto IA leggermente modificato.

- JustDone ha mostrato un buon equilibrio, ma — ripetiamo — nessuno strumento è infallibile.

Questi test confermano che, sebbene l'accuratezza dei rilevatori sia migliorata negli ultimi anni, siamo lontani dalla perfezione. I rilevatori sono strumenti di supporto, non verità assolute.

Puoi fidarti dei rilevatori di IA?

La risposta onesta: sono utili, ma non infallibili. Funzionano meglio come parte di un processo più ampio, non come giudice finale.

Ecco perché molte università italiane ed europee utilizzano i rilevatori come strumento di segnalazione iniziale, non come verdetto definitivo. Se il tuo lavoro viene segnalato, la maggior parte delle istituzioni lo rivede manualmente prima di procedere con qualsiasi accusa.

Questo approccio ha senso: la tecnologia può aiutare a identificare casi sospetti, ma la decisione finale dovrebbe sempre coinvolgere un essere umano che considera il contesto.

Consigli pratici per usare l'IA in modo responsabile

Se usi l'IA come supporto nella scrittura, ecco come farlo in modo etico e intelligente.

- Usa l’IA come supporto, non come ghostwriter. Ottieni feedback o schemi, ma scrivi la bozza finale da solo

- Rileggi tutto. Assicurati che il linguaggio rifletta la tua voce e conoscenza

- Controlla i tuoi scritti con JustDone AI Detector prima di consegnarli

- Se segnalato, spiega. Conserva bozze o appunti per mostrare il tuo processo di scrittura

Conclusioni: Comprendere l'Accuratezza dei Rilevatori di IA

I rilevatori di IA stanno migliorando, ma sono ancora fallibili. Gli studenti meritano strumenti giusti e accurati che supportino l'apprendimento, non che puniscano il lavoro onesto. Quindi, quando ci si chiede quanto siano accurati i rilevatori di IA, ricorda che la risposta dipende dallo strumento e dal contesto.

Tra tutti quelli che abbiamo testato, il Rilevatore IA di JustDone offre l'approccio più equilibrato. Mantiene bassi i falsi positivi mentre continua a individuare efficacemente il testo generato dall'IA.

Alla fine, i rilevatori di IA dovrebbero responsabilizzare sia studenti che insegnanti a impegnarsi in un apprendimento onesto e riflessivo. Usali saggiamente e non dimenticare mai il lato umano della scrittura.